Pesquisadores pedem que setor de tecnologia acompanhe os “pensamentos” de sistemas de IA

Um grupo que reúne cientistas da OpenAI, Google DeepMind, Anthropic, universidades e organizações sem fins lucrativos divulgou, nesta terça-feira, um documento defendendo que a indústria de tecnologia aprofunde os estudos sobre monitoramento dos chamados chains of thought (CoTs) — o processo externo em que modelos de inteligência artificial registram cada etapa de seu raciocínio. Segundo os autores, acompanhar essas “linhas de pensamento” pode se tornar um recurso essencial para manter agentes de IA sob controle à medida que ganham escala e complexidade.

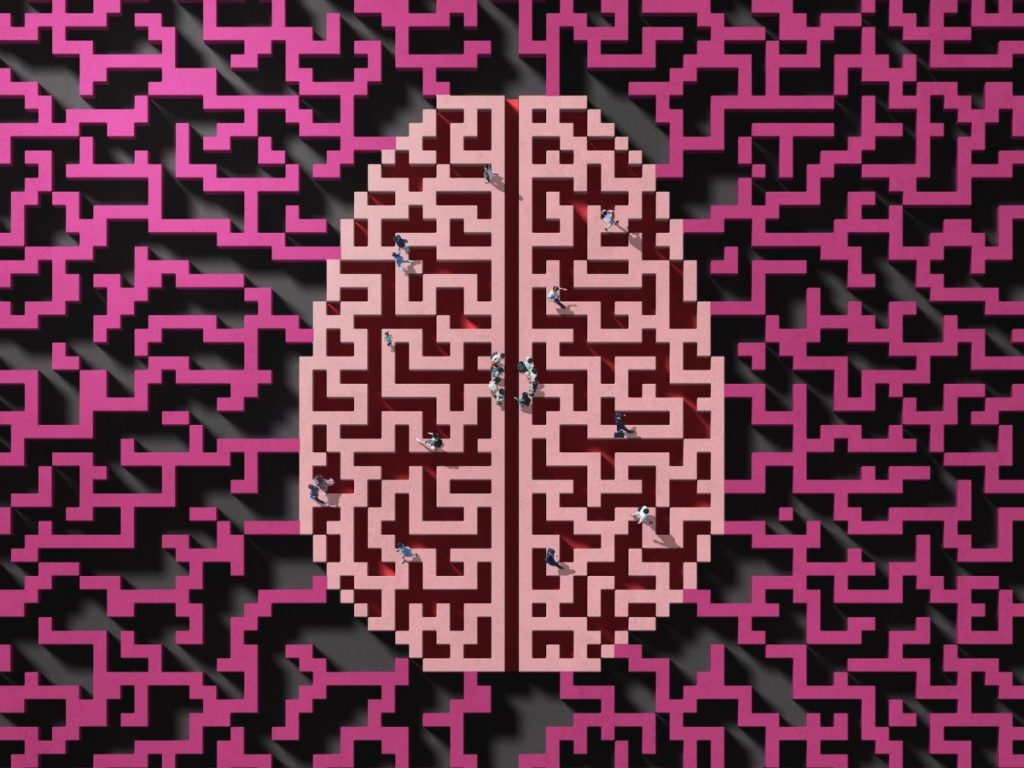

Os pesquisadores classificam os CoTs como um mecanismo semelhante ao rascunho utilizado por humanos para resolver problemas matemáticos: o modelo escreve, ajusta e revisa hipóteses antes de apresentar a resposta final. Essa transparência, apontam, oferece “uma rara janela” sobre como as decisões são tomadas por sistemas de última geração capazes de planejar, executar tarefas e interagir de forma autônoma.

No entanto, o texto alerta que a visibilidade atual não está garantida. Mudanças na arquitetura dos modelos ou em métodos de treinamento podem reduzir a clareza dessas cadeias de raciocínio, comprometendo seu valor como ferramenta de segurança. Por isso, o grupo recomenda que laboratórios identifiquem os fatores que aumentam ou diminuem a monitorabilidade, acompanhem métricas de transparência e evitem intervenções que fragilizem o acesso aos CoTs.

Entre os signatários estão nomes de destaque no campo da IA: Mark Chen (diretor de pesquisa da OpenAI), Ilya Sutskever (CEO da Safe Superintelligence), o laureado com o Nobel Geoffrey Hinton, Shane Legg (cofundador da Google DeepMind), Dan Hendrycks (assessor de segurança da xAI) e John Schulman (cofundador da Thinking Machines). Instituições como o UK AI Security Institute, METR, Apollo Research e Universidade da Califórnia em Berkeley também endossaram a iniciativa.

O apelo ocorre em um cenário de competição acirrada entre grandes empresas. Meta, por exemplo, tem atraído especialistas de OpenAI, Google DeepMind e Anthropic com propostas milionárias. Os profissionais mais disputados são justamente aqueles que desenvolvem agentes de IA e modelos de raciocínio, categoria na qual se enquadram sistemas como o o3, da OpenAI, e o R1, da DeepSeek.

Bases de dados e benchmarks mostram avanços rápidos desde que a OpenAI liberou, em setembro de 2024, uma prévia pública do modelo de raciocínio o1. Nos meses seguintes, Google DeepMind, xAI e Anthropic apresentaram versões que igualam ou superam esse desempenho. Apesar do progresso em resultados, os laboratórios reconhecem que ainda sabem pouco sobre o funcionamento interno desses sistemas.

Interpretabilidade — área dedicada a entender como a IA chega às conclusões — tornou-se prioridade. A Anthropic, que se destaca no tema, prometeu “abrir a caixa-preta” dos modelos até 2027 e aumentou investimentos nesse campo, incentivando OpenAI e Google DeepMind a fazer o mesmo. Pesquisas iniciais da companhia, contudo, sugerem que os CoTs podem não refletir totalmente o processo real de tomada de decisão, o que reforça a necessidade de avaliações sistemáticas.

Por outro lado, estudos da OpenAI apontam que o monitoramento das cadeias de raciocínio pode vir a ser um indicador confiável de alinhamento e segurança, caso a metodologia evolua. Para que esse potencial se concretize, o novo documento defende a criação de protocolos de mensuração e o financiamento de pesquisas independentes, de modo a evitar que a funcionalidade desapareça ou se torne menos acessível em futuras gerações de modelos.

O principal objetivo do posicionamento é atrair atenção e recursos para um campo considerado “embrionário”, mas estratégico. Os autores avaliam que, se o monitoramento de CoTs se consolidar como prática comum, desenvolvedores terão mais ferramentas para detectar desvios de comportamento, corrigir erros de lógica e prevenir usos maliciosos dos agentes de IA.

Ao final, o texto conclama empresas, universidades e órgãos reguladores a colaborarem no desenvolvimento de padrões que preservem a transparência dos modelos. A mensagem, destacam os signatários, é urgente: sem investigação coordenada agora, a oportunidade de acompanhar os “pensamentos” das máquinas poderá se perder justamente no momento em que elas avançam em velocidade inédita.